Apple sagsøgt for over 1 milliard dollars efter droppet funktion

Et milliardstort søgsmål mod Apple er indgivet i Northern California, efter Apple droppede et tiltag grundet sikkerhedsrisici.

For lige at få begrebet og læserne med, er det nok bedst at starte med en fortælling om, hvad CSAM er og gør.

CSAM står for Child Sexual Abuse Material og er billeder, videoer eller andet materiale, der viser seksuelt misbrug eller udnyttelse af børn.

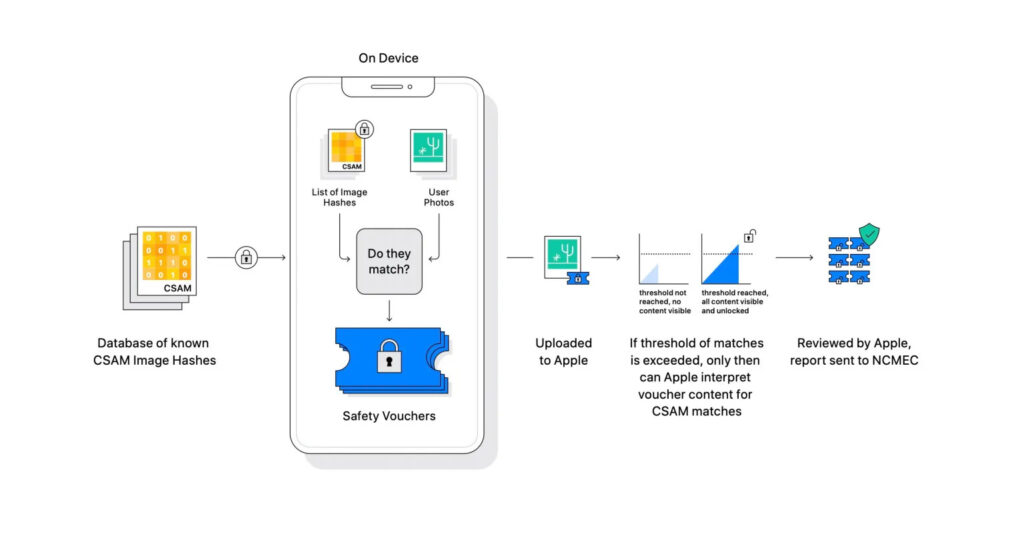

Tilbage i 2021 planlagde Apple at indbygge en slags CSAM-overvågning i iCloud Fotos. Dette skulle foregå igennem en on-device-skanning.

Indholdet, der skulle skannes, ville først blive transformeret til en ulæselig form, så det ikke var genkendeligt. Når billedet så blev uploadet til iCloud, ville det blive sammenholdt med en CSAM-database over billeder, som indeholder misbrug eller udnyttelse af børn.

Hvis der blev gjort udslag på et bestemt antal parametre, ville det blive manuelt gennemgået, og hvis der var noget om snakken, ville det blive sendt videre til myndigheder.

Dette efterlod en masse “hvis” og kunne også udgøre en sikkerhedsrisiko for ondsindede. Samtidig rejste det også debatten, om det ville give udslag, hvis man havde et billede af sin baby i et badekar, eksempelvis.

I sidste ende blev det først udskudt, og i 2022 annoncerede Apple, at de droppede det, inden det overhovedet var blevet indført.

LÆS MERE: Er Apple på vej med et HomeKit-kamera?

Apple sagsøgt for 1,2 milliarder dollars

Nu er Apple sagsøgt for 1,2 milliarder dollars i et søgsmål med over 2.680 ofre for misbrug af den ene eller anden grad, det fortæller Macrumors.

Søgsmålet skyldes Apples manglende evne til at indføre CSAM-overvågning på deres enheder i 2021 og er derfor en kompensation til ofre for misbrug.

I søgsmålet fortæller hovedsagsøgeren også, at hun stadig får beskeder fra myndigheder om, at de har fundet hendes billeder på mistænktes computere, og at hun derfor stadig gennemgår sit traume fra dengang.

Søgsmålet argumenterer for, at Apples vilje til ikke at fortsætte implementeringen har kostet traumer hos ofre for misbrug.

Det skal dog nævnes, at det ikke vides, om de 2.680 sagsøgere havde undgået de oplevelser, de har haft, hvis Apple havde implementeret CSAM.

LÆS MERE: PlayStation VR2 med Apple Vision Pro?

Mere til historien

I et modsvar fortæller en talsperson fra Apple, at de arbejder på at nedbringe antallet af digitalt misbrug af børn uden at gå på kompromis med sikkerheden og privatlivet. Her fremhæves Sikker Kommunikation, der kan komme med en advarsel på skærmen, hvis du er ved at få vist stødende indhold.